智能家居进入

AI时代

Hello Future

国内领先的智能家居系统提供商

更多精彩 与您共享

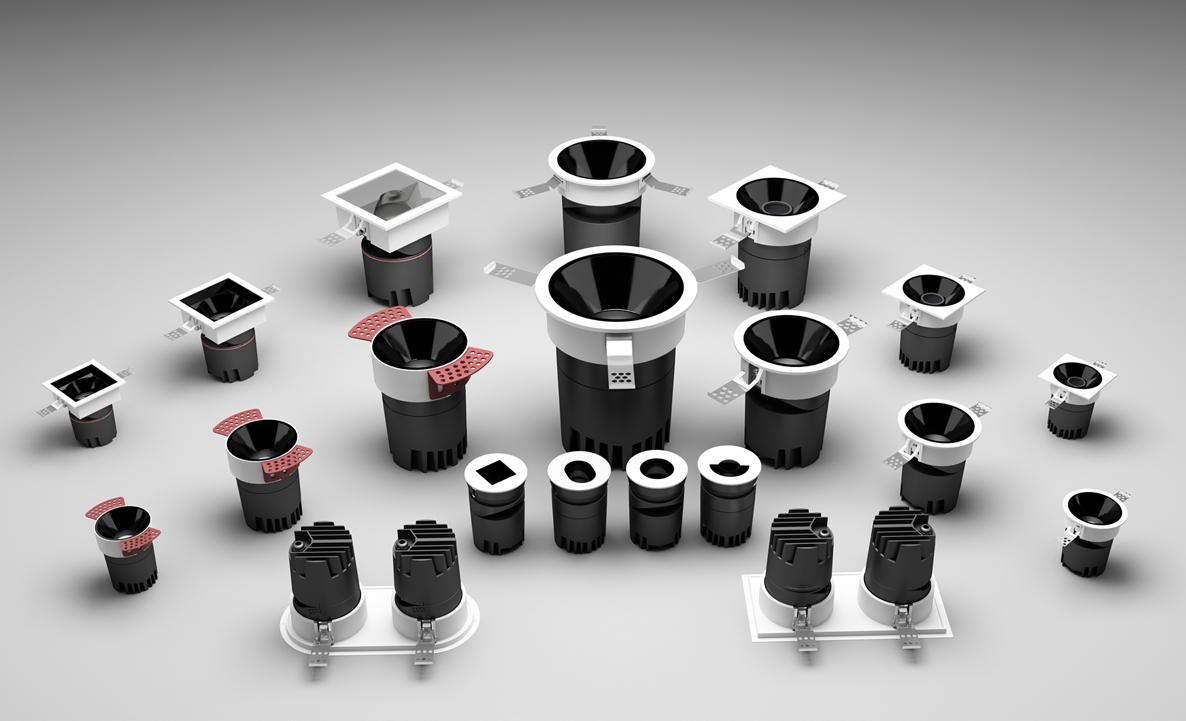

聪普智慧健康照明系列:定制光照配方,一键省心启动

聪普智慧健康照明系列:多种光学科技,极致舒适体验

宣传片欣赏:黑科技还原心中理想的家

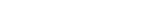

APanel魔方智能语音面板:复刻魔方之美

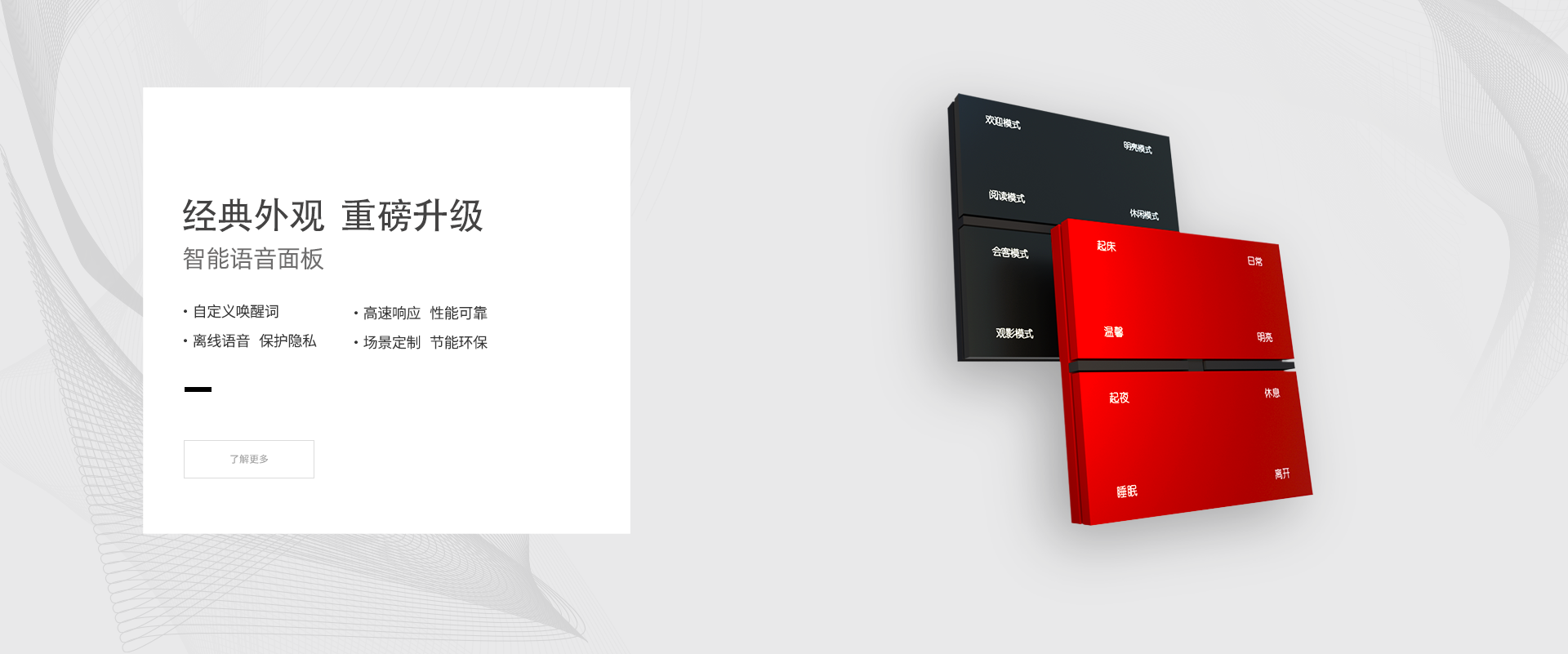

APanel音控面板:无需改线 超简安装

APanel 弧音功能演示视频

APanel弧音广告片欣赏:全屋语音 重塑体验

APanel弧音:开创全屋语音智能新时代

PLD-SKP系列智能面板:优雅与性能兼具

智能语音面板:个性场景,语音执行

PLD-C1系列智能主机:颠覆控智

品牌形象片:懂家 · 更懂你

贴心服务 邀您体验

智能生活 更近一步